Un nuovo strumento “avvelena” le immagini in modo che siano inutilizzabili dall’intelligenza artificiale generativa

I ricercatori hanno sviluppato un nuovo strumento che potrebbe aiutare a impedire agli sviluppatori di sistemi di intelligenza artificiale generativa di utilizzare immagini pubblicate sul web per addestrare i propri modelli senza autorizzazione. Questa tecnologia non consiste in una semplice protezione una tantum del business digitale: se implementata, cambierà le prestazioni di questi sistemi di intelligenza artificiale a lungo termine.

Dall’emergere dei modelli di intelligenza artificiale generativa, sono sorte forti tensioni tra la comunità tecnica e i giganti dell’intelligenza artificiale, tra cui Meta, OpenAI, Google e Stability AI. Per proteggere la propria creatività, gli artisti criticano queste aziende perché fanno affidamento sul loro lavoro per formare i propri modelli senza alcuna licenza o compenso.

In questo contesto controverso, un team di ricercatori dell’Università di Chicago, guidato da Bin Zhao, ha sviluppato uno strumento innovativo chiamato “Nightshade”. È stato creato al solo scopo di combattere l’uso non autorizzato delle immagini da parte delle società tecnologiche. Nightshade ha la capacità di “avvelenare” le immagini in modo che siano controproducenti per l’IA, diventando così inutilizzabili per il suo addestramento. Questa è la rivista Revisione della tecnologia del MIT

Chi ha svelato questo strumento, avendo già ricevuto un’anteprima esclusiva del documento di ricerca associato.

Uno strumento per gli artisti

Nightshade consente ai creatori di aggiungere modifiche impercettibili ai pixel delle loro creazioni prima di caricarle. Queste modifiche consentono di destabilizzare l’addestramento dei modelli di intelligenza artificiale. Pertanto, se il modello viene addestrato utilizzando lavori elaborati utilizzando Nightshade, i risultati risultanti sono radicalmente diversi da quanto previsto. Il team di ricerca prevede di rendere lo strumento disponibile a tutti come open source, il che potrebbe renderlo più potente e disponibile in diverse versioni.

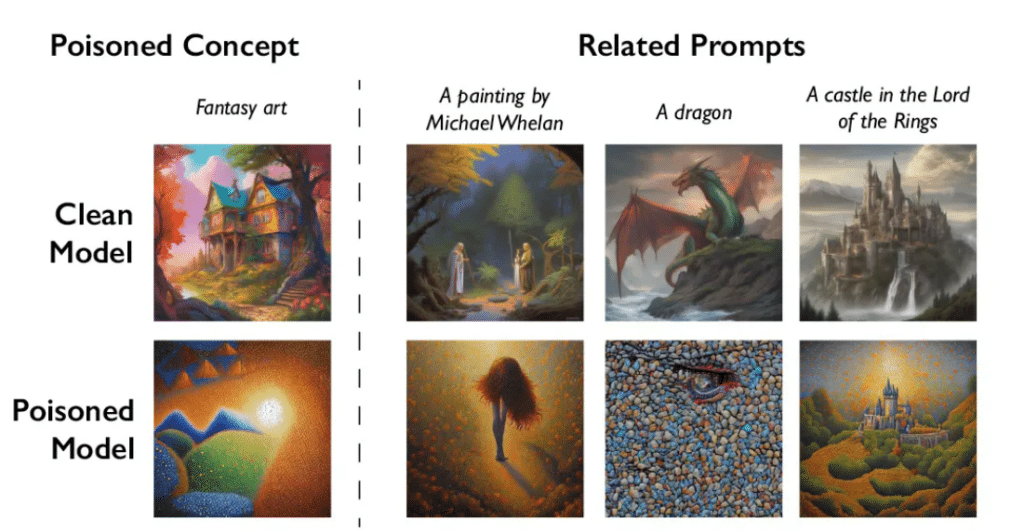

Confronto tra le immagini generate utilizzando un modello AI normale e quelle generate utilizzando un modello AI “avvelenato”. ©Bin Zhao W

IL. Nella revisione della tecnologia del MIT

Va notato che Ben Zhao ha effettivamente progettato la tecnologia Glaze, che è simile alla tecnologia Nightshade che abbiamo introdotto poche settimane fa. Quest’altro strumento sovrappone un livello separato all’immagine. Il filtro è impercettibile per l’uomo, ma per l’intelligenza artificiale cambia completamente lo stile artistico dell’opera, portando a interpretazioni errate.

Separatamente, il team di Zhao prevede di integrare Nightshade con Glaze, offrendo agli artisti maggiore protezione. Pertanto, quando presenteranno il proprio lavoro online, potranno scegliere lo strumento che preferiscono, che si tratti di Nightshade, Glaze o di una combinazione dei due.

Meccanico delle melanzane

Concretamente, Nightshade funziona sfruttando una vulnerabilità riscontrata nei modelli di intelligenza artificiale generativa. Introducendo campioni di immagini “avvelenate” (qui con Nightshade) nei dati utilizzati per addestrare l’IA, è possibile introdurre errori significativi.

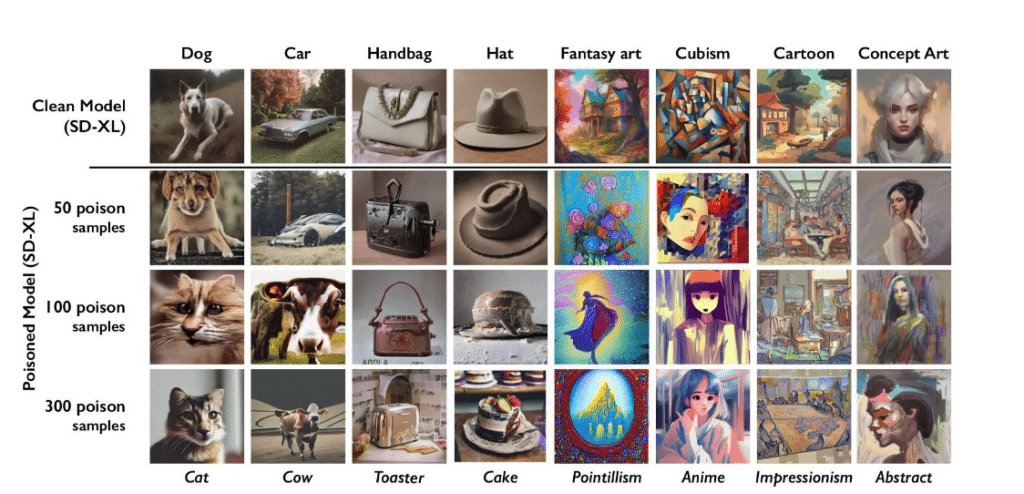

Inoltre, i ricercatori hanno ottenuto risultati sorprendenti dopo i primi test utilizzando questo strumento. Sono riusciti a ingannare l’intelligenza artificiale a tal punto da percepire le immagini di cappelli come immagini di torte e le immagini di borse come immagini di tostapane. Quindi, quando hanno chiesto all’intelligenza artificiale di fornire l’immagine di un cappello o di una borsa, sono state fornite rispettivamente immagini di torte o tostapane.

Desideri rimuovere gli annunci dal sito

Continuando a sostenerci ?

E’ semplice, basta iscriversi!

Al momento, Sconto del 20%. Su un abbonamento annuale!

Gli scienziati hanno anche cercato di affrontare modelli di diffusione stazionaria. Per prima cosa hanno combinato 50 campioni di immagini avvelenate di cani. Quindi, in risposta alla richiesta di creare l’immagine di un cane, l’intelligenza artificiale ha prodotto una strana creatura che somigliava poco ai cani. La cosa ancora più interessante è che dopo aver ricevuto 300 immagini tossiche di cani, l’intelligenza artificiale ha finito per creare invece l’immagine di un gatto.

Rappresentazione delle immagini generate dal modello in base al numero di immagini tossiche utilizzate (da 0 a 300). ©Bin Zhao W

IL. Nella revisione della tecnologia del MIT

Il punto cruciale da ricordare è che Nightshade non influenza solo un termine. Disabilita tutte le parole correlate all’interno di un dato campo lessicale. Tuttavia, nonostante il suo potenziale, questa tecnologia non è priva di rischi. Secondo le informazioni che hai fornito Revisione della tecnologia del MITÈ possibile, ad esempio, abusarne per scopi dannosi. Bin Zhao vuole però fugare ogni timore, perché secondo lui per destabilizzare con successo grandi modelli di intelligenza artificiale sono necessarie migliaia di immagini avvelenate.

“Pioniere del caffè a misura di hipster. Creatore amichevole. Analista pluripremiato. Scrittore. Studioso di cibo. Drogato di televisione. Ninja di Internet.”